Indispensables, son pruebas matemáticas que se aplican a las estadísticas para determinar su grado de certeza y su significado.

Los métodos estadísticos interferenciales no paramétricos:

Son procedimientos matemáticos para testar la hipótesis estadística que, al contrario de la estadística paramétrica, no hacen ninguna asunción sobre las distribuciones de frecuencia de las variables que son determinadas.

El nivel de medición puede ser nominal u ordinal.

La muestra no tiene que ser aleatoria.

La distribución de la frecuencia no tiene que ser normal.

Se puede usar con muestras más pequeñas.

Los métodos estadísticos deductivos paramétricos:

Son los procedimientos matemáticos para testar la hipótesis estadística que asumen que las distribuciones de las variables determinadas tienen ciertas características.

El nivel de medición debe ser racional o intervalar.

La muestra debe ser aleatoria.

La distribución de la frecuencia debe ser normal.

La variación de resultados entre cada frecuencia debe ser similar.

| Variable de respuesta | ||||

|---|---|---|---|---|

|

Factor de estudio |

Cualitativa nominal (dos categorías) |

Cualitativa nominal (> 2 categorías) |

Cualitativa ordinal |

Cuantitativa |

|

Cualitativo (dos grupos) |

|

|

|

|

|

Independientes |

Z de comparación de proporciones. Chi al cuadrado. Prueba exacta de Fisher. |

Chi al cuadrado. |

U de Mann-Whitney. |

t de Student-Fisher. Prueba de Welch.

|

|

Apareados |

Prueba de McNemar. Prueba exacta de Fisher. |

Q de Cochran. |

Prueba de los signos. Prueba de los rangos signados de Wilcoxon. |

t de Student-Fisher para datos apareados. |

|

Cualitativo (más de dos grupos) |

|

|

|

|

|

Independientes |

Chi al cuadrado. |

Chi al cuadrado. |

Prueba de Kruskal-Wallis. |

Análisis de la variancia. |

|

Apareados |

Q de Cochran. |

Q de Cochran. |

Prueba de Friedman. |

Análisis de la variancia de dos vías. |

|

Cuantitativo |

t de Student-Fisher. |

Análisis de la variancia. |

Correlación de Spearman. Tau de Kendall. |

Correlación de Pearson. Regresión lineal. |

Cuando las pruebas estadísticas aplicables a las variables cuantitativas no cumplen las asunciones necesarias para su aplicación, deben utilizarse las pruebas correspondientes como si las variables de respuesta fuera una variable ordinal (pruebas no paramétricas).

PRUEBA DE KOLMOGOROV-SMIRNOV

Prueba de significación estadística no paramétrica para contrastar la hipótesis nula cuando los parámetros de localización de ambos grupos son iguales.

Este contraste, que es válido únicamente para variables continuas, compara la función de distribución (probabilidad acumulada) teórica con la observada, y calcula un valor de discrepancia, representado habitualmente como D, que corresponde a la discrepancia máxima en valor absoluto entre la distribución observada y la distribución teórica, proporcionando asimismo un valor de probabilidad P, que corresponde, si estamos verificando un ajuste a la distribución normal, a la probabilidad de obtener una distribución que discrepe tanto como la observada si verdaderamente se hubiera obtenido una muestra aleatoria, de tamaño n, de una distribución normal.

Si esa probabilidad es grande no habrá por tanto razones estadísticas para suponer que nuestros datos no proceden de una distribución, mientras que si es muy pequeña, no será aceptable suponer ese modelo probabilístico para los datos.

PRUEBA DE F

Prueba estadística que sirve para comparar varianzas.

El estadístico F experimental es el estadístico de contraste en el ANOVA y otras pruebas de comparación de varianzas.

TEST DE CHI AL CUADRADO

La prueba de Ji-cuadrado es cualquier prueba estadística de la hipótesis en cuál el test estadístico de la distribución del Ji-cuadrado si la hipótesis nula es verdad.

Determina si existe asociación entre variables cualitativas.

Si el p-valor asociado al estadístico de contraste es menor se rechazará la hipótesis nula.

Se utiliza para analizar tablas de contingencia y comparación de proporciones en datos independientes

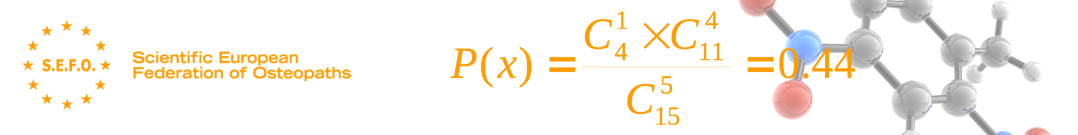

PRUEBA EXACTA DE FISHER (p.- 5%)

Permite valorar el efecto del azar.

Es una prueba estadística de significación usada en el análisis de los tamaños pequeños categóricos de muestra de datos.

La necesidad de la prueba de Fischer se presenta cuando tenemos datos que se dividan en dos categorías de dos maneras separadas.

Prueba de significación estadística utilizada para comparar proporciones en tablas de contingencia.

Es preferible a la prueba de x2 cuando el tamaño de la muestra es reducido (de menos de 30 efectivos).

Es la prueba estadística de elección cuando la prueba de Chi cuadrado no puede ser empleada por tamaño muestral insuficiente

PRUEBA DE MCNEMAR.

Prueba estadística que sirve para comparar proporciones en datos pareados.

Prueba de significación estadística para probar la hipótesis nula de inexistencia de cambios en la proporción de sujetos que experimentan un acontecimiento, cuando cada individuo es evaluado dos veces (en condiciones diferentes) y los datos están emparejados.

PRUEBA BINOMIAL

En estadística, la prueba binomial es una prueba exacta de la significación estadística de desviaciones de una distribución teóricamente prevista de observaciones en dos categorías.

El uso más común de la prueba binomial es en el caso donde la hipótesis nula es que dos categorías son igualmente probables ocurrir.

TEST DE CORRELACIÓN DE PEARSON

Se utiliza para estudiar la asociación entre un factor de estudio y una variable de respuesta cuantitativa, mide el grado de asociación entre dos variables tomando valores entre -1 y 1.

- Valores próximos a 1 indicarán fuerte asociación lineal positiva.

- Valores próximos a -1 indicarán fuerte asociación lineal negativa.

- Valores próximos a 0 indicarán no asociación lineal, lo que no significa que no pueda existir otro tipo de asociación.

Prueba en una hipótesis nula que las frecuencias relativas de la ocurrencia de acontecimientos observados siguen una distribución de frecuencia especificada.

Los acontecimientos deben ser mutuamente exclusivos.

Es una prueba de la calidad de ajuste que establece sí o no una distribución de frecuencia observada diferencia de una distribución teórica.

COEFICIENTE DE KAPPA

El Kappa es un índice ómnibus de aceptación en los estudios inter-observadores, indica el grado de interrelación inter-observador.

Permite cuantificar el nivel del acuerdo inter-observador para disminuir la subjetividad del método utilizado (test de movilidad) y si el grado de acuerdo se debe al azar (a la suerte).

El porcentaje de acuerdo acompañado del índice de Kappa se utiliza para las variables cualitativas.

Se habla del coeficiente de Kappa de Cohen para dos terapeutas y de Fleiss para más de dos terapeutas.

Este coeficiente está comprendido entre 0 y 1. 0, corresponde a una correlación que es idéntica a la encontrada por casualidad y 1 una correlación perfecta entre los exámenes.

Los valores negativos indican habitualmente que existe un desacuerdo en la manera de realizar el método entre los terapeutas.

Se calcula como la proporción de acuerdo, aparte del que ya sería de esperar por azar, que ha sido observado entre dos repeticiones del mismo instrumento (por ejemplo, un juicio realizado por dos observadores por separado).

El coeficiente máximo de concordancia es de 1.00.

Un valor de 0.00 indica ninguna concordancia.

- entre 0.00 y 0.20: ligera.

- entre 0.21 y 0.40: pasable

- entre 0.41 y 0.60: moderada

- entre 0.61 y 0.80: importante

- entre 0.81 y 1.00: perfecta.

Un coeficiente de 0.4 puede considerarse como el límite de fiabilidad aceptable de una prueba

El kappa es”un corrector de la medida de acuerdo”.

Como test de estadística, el kappa puede verificar que el acuerdo exceda los niveles de suerte

Todos los bloques |

bloque C2-C4 | bloque C5-6 | |

|---|---|---|---|

| Valor del Kappa | K = 0.675 SE = 0.041 Z = 17.067 |

K = 0.756 SE = 0.045 Z = 16.823 |

K = 0.460 SE = 0.091 Z = 5.039 |

| Especificidad | 98% | 98% | 91% |

| Sensibilidad | 74% | 78% | 55% |

K = coeficiente de Kappa, SE = error estándar, Z =Test de especificidad de la estadística.

COEFICIENTE DE CORRELACIÓN INTRACLASE (ICC)

El coeficiente de correlación intraclase (ICC) para las variables cuantitativas.

Utiliza el modelo 2 de Landis y Koch para la fiabilidad interexaminador, y el modelo 3 para la fiabilidad intraexaminadores (Landis RJ et Koch GG, 1977).

Este índice está también comprendido entre 0 y 1.

– El valor 1 corresponde a una reproductividad perfecta entre las mediciones.

– El valor 0 indicaría que existe la misma variancia entre las mediciones tomadas sobre un único paciente que las mediciones tomadas entre diferentes pacientes.

| TESTS | ICC | KAPPA |

|---|---|---|

| Altura crestas ilíacas | 52 | 0.26 |

| Altura EIPS | 75 | 0.54 |

| TFD | 82 | 0.62 |

| TFS | 63 | 0.26 |

| Gillet | 60 | 0.18 |

| Elev. activa pierna extendida | 93 | 0.81 |

| Joint play | 75 | 0.61 |

| Thigh thrust | 81 | 0.73 |

| Separación | 58 | 0.17 |

| Gaenslen | 80 | 0.51 |

| Patrick | 80 | 0.65 |

| Sacral thrust | 68 | 0.38 |

| Sensibilidad ligamento SI. | 91 | 0.83 |

| Compresión | 85 | 0.59 |

TEST DE CORRELACIÓN DE SPEARMAN

Es una medición no paramétrica de correlación, asume una función monotónica arbitraria para describir la relación entre dos variables, sin hacer ningunas asunciones sobre la distribución de frecuencia de las variables.

A la diferencia del coeficiente del test de Pearson, no requiere la asunción que la relación entre las variables es linear, ni que las variables sean medidas en escalas del intervalo; puede ser utilizado para variables medidas en nivel ordinal.

Se utiliza si no se cumplen las condiciones de aplicación del test de Pearson.

Es una variante del test de correlación de Pearson se aplica cuando cada valor en sí no es tan importante como su situación respecto a los restantes.

Sus valores se interpretan exactamente igual que los del coeficiente de correlación de Pearson.

La correlación de Spearman mide el grado de asociación entre dos variables cuantitativas que siguen una tendencia siempre creciente o siempre decreciente.

Es más general que el Coeficiente de correlación de Pearson, la correlación de Spearman, en cambio se puede calcular para relaciones exponenciales o logarítmicas entre las variables.

TEST DE WILCOXON

Contrasta la hipótesis nula de que la muestra procede de una población en la que la magnitud de las diferencias positivas y negativas entre los valores de las variables es la misma.

Prueba estadística no paramétrica para la comparación de dos muestras (dos tratamientos).

Las distribuciones de datos no necesitan seguir la distribución normal.

Es por tanto una prueba menos restrictiva que la prueba t-Student.

PRUEBA DE SHAPIRO-WILKS.

Aunque esta prueba es menos conocida es la que se recomienda para contrastar el ajuste de nuestros datos a una distribución normal, sobre todo cuando la muestra es pequeña (n<30).

Mide el ajuste de la muestra a una recta, al dibujarla en papel probabilístico normal.

PRUEBA “t” DE STUDENT-FISHER

Si se comparan dos grupos respecto a una variable cuantitativa.

En caso contrario, se utiliza una prueba no paramétrica equivalente, como la U de Mann-Whitney.

Se utiliza para la comparación de dos medias de poblaciones independientes y normales.

Prueba de significación estadística paramétrica para contrastar la hipótesis nula respecto a la diferencia entre dos medias.

Cuando las dos medias han sido calculadas a partir de dos muestras completamente independientes de observaciones (situación poco probable en la práctica, por lo menos desde un punto de vista teórico), la prueba se describe como no emparejada.

Cuando las dos medias han sido extraídas de observaciones consecutivas en los mismos sujetos en dos situaciones diferentes, se comparan los valores de cada individuo, y se aplica una prueba emparejada.

La prueba “t” de Student es un tipo de estadística deductiva.

Se utiliza para determinar si hay una diferencia significativa entre las medias de dos grupos.

Con toda la estadística deductiva, asumimos que las variables dependientes tienen una distribución normal.

Especificamos el nivel de la probabilidad (nivel de la alfa, nivel de la significación, p) que estamos dispuestos a aceptar antes de que cerco datos (p < .05 es un valor común que se utiliza).

Notas sobre la prueba t de Student:

- Cuando la diferencia entre dos promedios de la población se está investigando, se utiliza una prueba t. Es decir que se utiliza cuando deseamos comparar dos medias (las cuentas se deben medir en una escala de intervalo o de cociente).

- Utilizaríamos una prueba t si deseamos comparar el logro de la lectura de hombres y de mujeres.

- Con una prueba t, tenemos una variable independiente y una dependiente.

- La variable independiente (género en este caso) puede solamente tener dos niveles (varón y hembra).

- Si la independiente tuviera más de dos niveles, después utilizaríamos un análisis de la variación unidireccional (ANOVA).

- La prueba estadística para t de Student es el valor t. Conceptualmente, la t-valor representa el número de unidades estándares que están separando las medias de los dos grupos.

- Con una t-prueba, el investigador desea indicar con un cierto grado de confianza que la diferencia obtenida entre los medios de los grupos de la muestra sea demasiado grande ser un acontecimiento chance.

- Si nuestra t-prueba produce una t-valor que da lugar a una probabilidad de .01, decimos que la probabilidad de conseguir la diferencia que encontramos sería por casualidad 1 en 100 veces.

Cinco factores contribuyen para indicar si la diferencia entre dos medias de los grupos se puede considerar significativa:

- Cuanto mayor es la diferencia entre las dos medias, mayor es la probabilidad que una diferencia estadística significativa existe.

- La cantidad de traslapo que existe entre los grupos (es una función de la variación dentro de los grupos). Cuantas más pequeñas son las variaciones que existen entre los dos grupos, mayor es la probabilidad que una diferencia estadística significativa existe.

- El tamaño de la muestra es extremadamente importante en la determinación de la significación de la diferencia entre las medias. Aumentando el tamaño de la muestra, las medias tienden a ser más estables y más representativas.

- Un nivel más grande de la alfa requiere menos diferencia entre las medias (p < .05).

- Se debe utilizar una hipótesis (con dos colas) no directivas.

Asunciones subyacentes la prueba de t:

- Las muestras se han dibujado aleatoriamente a partir de sus poblaciones respectivas.

- La población se debe distribuir normalmente.

- Unimodal (un modo).

- Simétrico (las mitades izquierdas y derechas son imágenes espejo), el mismo número de gente arriba o abajo de la media.

- Acampanado (altura máxima (moda) en el medio).

- Media, moda, y mediana se localizan en el centro.

- Asintótico (cuanto más lejos se aleja la curva de la media, más cercana será el eje de X; pero la curva nunca debe tocar el eje de X).

- El número de personas en las poblaciones debe tener la misma varianza (s2 = s2).Si no es el caso se utiliza otro cálculo para el error estándar.

Existen 2 tipos de prueba t de Student

- Test t para diferencia par ( grupos dependientes, test t correlacionado) : df= n (número de pares) -1

Esto se refiere a la diferencia entre las cuentas medias de una sola muestra de individuos que se determina antes del tratamiento y después del tratamiento. Puede también comparar las cuentas medias de muestras de individuos que se aparean de cierta manera (por ejemplo los hermanos, madres, hijas, las personas que se emparejan en términos de las características particulares). - Test t para muestras independientes

Esto se refiere a la diferencia entre los promedios de dos poblaciones.

Básicamente, el procedimiento compara los promedios de dos muestras que fueron seleccionadas independientemente una de la otra.

Un ejemplo sería comparar cuentas matemáticas de un grupo experimental con un grupo de control.

¿Cómo decido qué tipo de t-prueba a utilizar?

Error tipo I:

- Rechaza una hipótesis nula que sea realmente verdad. La probabilidad de hacer un error tipo I depende del nivel alfa que se Eligio.

- Si se fijó la probabilidad alfa en p < 05, entonces existe un 5% de posibilidades de hacer un error de tipo I.

- Se puede reducir la posibilidad de hacer un error tipo I fijando un nivel alfa más pequeño (p < .01). El problema haciendo esto es que se aumenta la posibilidad de un error tipo II.

Error tipo II:

- Falla en rechazar una hipótesis nula que sea falsa.

- La idea básica para calcular una prueba de Student es encontrar la diferencia entre las medias de los dos grupos y dividirla por el error estándar (de la diferencia), es decir la desviación de estándar de la distribución de las diferencias.

- Un intervalo de confianza para una prueba t con dos colas es calculado multiplicando los valores críticos por el error de estándar y agregando y restando eso de la diferencia de las dos medias.

- El efecto tamaño se utiliza para calcular la diferencia práctica. Si existen varios miles de pacientes, es muy fácil encontrar una diferencia estadísticamente significativa.

- Saber si esa diferencia es práctica o significativa es otra pregunta.

- Con los estudios implicando diferencias de grupo, el tamaño del efecto es la diferencia de las dos medias dividido por la desviación estándar del grupo control (o la desviación estándar media de ambos grupos si no hay grupo de control).

- Generalmente, el tamaño del efecto es solamente importante si existe una significación estadística.

- Un efecto tamaño de 2 se considera pequeño, 5 se considera medio, y 8 se considera grande.

TEST DE MANN-WHITNEY

La prueba de Mann-Whitney U es una de las pruebas de significación más conocidas.

Es apropiada cuando dos muestras independientes de observaciones se miden en un nivel ordinal, es decir que podemos decir cuál es la mayor de estas dos observaciones.

Determina si el grado de coincidencia entre dos distribuciones observadas es inferior a la esperada por suerte en la hipótesis nula que las dos muestras vienen de una misma población.

Prueba de significación estadística no paramétrica para probar la hipótesis nula de que el parámetro de localización (generalmente la mediana) es el mismo cuando se comparan dos grupos independientes, cualquiera que sea el tipo de distribución de la variable (distribución normal o de otro tipo).

Se usa cuando se quiere comparar dos poblaciones usando muestras independientes, es decir; es una prueba alterna a la prueba de t para comparar dos medias usando muestras independientes.

La hipótesis nula es que la mediana de las dos poblaciones son iguales y la hipótesis alterna puede ser que la mediana de la población 1 sea mayor (menor ó distinta) de la mediana de la población 2.

Prueba de Mann-Whitney para muestras independientes:

- Si tenemos dos series de valores de una variable continua obtenidas en dos muestras independientes: X1, X2,…, Xn, Y1, Y2,…, Ym, procederemos a ordenar conjuntamente todos los valores en sentido creciente, asignándoles su rango, corrigiendo con el rango medio los empates.

- Calculamos luego la suma de rangos para las observaciones de la primera muestra Sx, y la suma de rangos de la segunda muestra Sy.

- Si los valores de la población de la que se extrajo la muestra aleatoria de X se localizan por debajo de los valores de Y, entonces la muestra de X tendrá probablemente rangos más bajos, lo que se reflejará en un valor menor de Sx del teóricamente probable.

- Si la menor de las sumas de rangos es excesivamente baja, muy improbable en el caso de que fuera cierta la hipótesis nula, ésta será rechazada.

PRUEBA DE KRUSKAL-WALLIS

Prueba de significación estadística no paramétrica para contrastar la hipótesis nula cuando los parámetros de localización de dos o más grupos son iguales.

La prueba de Kruskal-Wallis, es una alternativa a la prueba F del análisis de varianza para diseños de clasificación simple. En este caso se comparan varios grupos pero usando la mediana de cada uno de ellos, en lugar de las medias.

La prueba de Kruskal-Wallis, es una alternativa a la prueba F del análisis de varianza para diseños de clasificación simple.

En este caso se comparan varios grupos pero usando la mediana de cada uno de ellos, en lugar de las medias.

- Ho: La mediana de las k poblaciones consideradas son iguales y,

- Ha: Al menos una de las poblaciones tiene mediana distinta a las otras.

Donde, n es el total de datos.

Este contraste, que es válido únicamente para variables continuas, compara la función de distribución (probabilidad acumulada) teórica con la observada, y calcula un valor de discrepancia, representado habitualmente como D, que corresponde a la discrepancia máxima en valor absoluto entre la distribución observada y la distribución teórica, proporcionando asimismo un valor de probabilidad P, que corresponde, si estamos verificando un ajuste a la distribución normal, a la probabilidad de obtener una distribución que discrepe tanto como la observada si verdaderamente se hubiera obtenido una muestra aleatoria, de tamaño n, de una distribución normal.

Si esa probabilidad es grande no habrá por tanto razones estadísticas para suponer que nuestros datos no proceden de una distribución, mientras que si es muy pequeña, no será aceptable suponer ese modelo probabilístico para los datos.

PRUEBAS NO-PARAMÉTRICAS

El análisis de la variación asume que las distribuciones subyacentes están distribuidas normalmente y que las variaciones de las distribuciones que son comparadas son similares.

El coeficiente de correlación de Pearson asume normalidad.

Mientras que las técnicas paramétricas son robustas (es decir, conservan a menudo un poder considerable para detectar diferencias o semejanzas incluso cuando se violan estas asunciones), algunas distribuciones violan tanto que un alternativa no paramétrica es más deseable para detectar una diferencia o una semejanza.

Pruebas no paramétricas para muestras relacionadas

| Prueba | Núm. devariables | Variables | Objetivo |

|---|---|---|---|

| McNemar | 2 | Cualitativas: 2 valores | Determinar si la diferencia entre las distribuciones de frecuencias de los valores de las dos variables es estadísticamente significativa. |

| Signos | 2 | En escala al menos ordinal | Determinar si la diferencia entre el número de veces en que el valor de una variable es mayor que el de la otra y el número de veces en que es menor es estadísticamente significativa. |

| Wilcoxon | 2 | En escala al menos ordinal | Determinar si la diferencia entre la magnitud de las diferencias positivas entre los valores de las dos variables y la magnitud de las diferencias negativas es estadísticamente significativa. |

| Q de Cochran | p > 2 | Cualitativas: 2 valores | Determinar si las diferencias entre las distribuciones de frecuencias de los valores de las p variables son estadísticamente significativas. |

| F de Friedman | p > 2 | En escala al menos ordinal | Determinar si las diferencias entre las distribuciones de las p variables son estadísticamente significativas. |

ELECCIÓN DE LA TÉCNICA ESTADÍSTICA APROPIADA

Con los elementos definidos en los párrafos anteriores se pueden establecer árboles de decisión para la ayuda en la elección de la técnica o prueba estadística apropiada.

Existen más de 300 pruebas estadísticas básicas, con lo que es difícil poder abordarlas todas de forma exhaustiva en este artículo.

|

Criterio |

Descripción |

Aclaraciones |

|---|---|---|

|

1 |

Estadística descriptiva

|

Ningún contenido estadístico o únicamente estadística descriptiva

|

|

2 |

Pruebas t de Student, pruebas z

|

Para una muestra o dos muestras (datos apareados y/o independientes)

|

|

3 |

Tablas bivariables

|

Chi cuadrado, prueba exacta de Fisher, test de MC Nemar

|

|

4 |

Tests no paramétricos

|

Test de los signos. U de Mann-Whitney, prueba t de Wilcoxon

|

|

5 |

Estadísticas demo-epidemiológicos

|

Riesgo relativo. Odds ratio. Log. Odds. Medidas de asociación. sensibilidad y especificidad

|

|

6 |

Correlación lineal de Pearson

|

Correlación clásica (coeficiente r de correlación lineal)

|

|

7 |

Correlación lineal de Pearson

|

Correlación clásica (coeficiente r de correlación lineal)

|

|

8 |

Regresión simple

|

Regresión de mínimos cuadrados con una variable productora y una respuesta

|

|

9 |

Análisis de varianza

|

ANOVA, análisis de la covarianza, pruebas F

|

|

10 |

Transformación de variables

|

Empleo de transformaciones (logarítmicas….)

|

|

11 |

Correlación no paramétrica

|

Rho de Spearman, Tau de Kendall, pruebas de tendencia

|

|

12 |

Regresión múltiple

|

Incluye la regresión polinómica y la regresión paso a paso

|

|

13 |

Comparaciones múltiples

|

Comparaciones múltiples

|

|

14 |

Ajuste y estandarización

|

Estandarización de tasas de incidencia y prevalencia

|

|

15 |

Tablas multivariables

|

Procedimientos de Mantel-Haenszel- modelos log. lineales

|

|

16 |

Potencia y tamaño muestral

|

Determinación del tamaño de la muestra en la base a una diferencia detectable

|

|

17 |

Análisis de la supervivencia

|

Incluye tablas de vida, regresión de supervivencia y otros análisis de supervivencia

|

|

18 |

Análisis coste- beneficio

|

Estimación de los costes de salud para comparar directrices alternativas (coste- efectividad)

|

|

19 |

Otros análisis

|

Test no incluidos en las categorías precedentes: análisis de Sensibilidad, análisis cluster. Análisis discriminante. |

Protocolo diseñado por EMERSON y COLDTIZ y adaptado por MORA RIPOLL y COLS. Niveles de referencia para el análisis de accesibilidad

LOS PASOS SIGUIENTES

Una vez realizadas las estadísticas se debe proceder a:

- Análisis cualitativo o cuantitativo.

- Síntesis e interpretación final de todos los datos ya analizados.

- Redacción el informe de investigación.