Sono indispensabili: prove matematiche che si applicano alla statistica per determinarne il grado di certezza e la significatività.

I metodi statistici interferenziali non parametrici:

Sono procedimenti matematici finalizzati a testare la ipotesi statistica che, al contrario della statistica parametrica, non fanno alcun assunto riguardo le distribuzioni di frequenza delle variabili che sono determinate.

Il livello di misurazione può essere nominale o ordinale.

Il campione non deve essere aleatorio.

La distribuzione di frequenza non deve essere normale.

Si possono usare con campioni più piccoli.

I metodi statistici deduttivi parametrici:

Sono procedure matematiche per verificare le ipotesi statistiche che assumono che le distribuzioni delle variabili determinate abbiano certe caratteristiche.

Il livello di misurazione di rapporto o di intervallo.

Il campione deve essere aleatorio.

La distribuzione della frequenza deve essere normale.

La variazione dei risultati tra ogni frequenza deve essere similare.

|

Variabili di

|

risposta |

|||

|

Fattore di studio |

Qualitativa nominale (due categorie) |

Qualitativa nominale (> 2 categorie) |

Qualitativa ordinale |

Quantitativa |

|

Qualitativo (due gruppi) |

||||

|

Indipendenti |

Z di confronto delle proporzioni. Chi al quadrato. Prova esatta di Fisher. |

Chi al quadrato. |

U di Mann-Whitney. |

t de Student-Fisher. Prueba de Welch.

|

|

Accoppiati |

Prova di McNemar. Prova esatta di Fisher. |

Q di Cochran. |

Prova dei segni. Prova dei range contrassegnati di Wilcoxon. |

t di Student-Fisher per dati appaiati. |

|

Qualitativo (più di due gruppi) |

||||

|

Indipendenti |

Chi al quadrato. |

Chi al quadrato. |

Prova di Kruskal-Wallis. |

Analisi della varianza. |

|

Accoppiati |

Q di Cochran. |

Q di Cochran. |

Prova di Friedman. |

Analisi della varianza di due vie. |

|

Quantitativo |

t di Student-Fisher. |

Analisi della varianza. |

Correlazione di Spearman. Tau di Kendall. |

Correlazione di Pearson. Regressione lineare. |

Quando le prove statistiche applicabili alle variabili quantitative non soddisfano i presupposti necessari per la loro realizzazione, si devono utilizzare le prove corrispondenti come se le variabili di risposte fossero variabili ordinali (prove non parametriche).

PROVA DI KOLMOGOROV-SMIRNOV

Test della significatività statistica non parametrica per testare l’ipotesi nulla quando i parametri di posizione di entrambi i gruppi sono uguali.

Questo contrasto, valido unicamente per le variabili continue, compara la funzione della distribuzione (probabilità accumulata) teorica con quella osservata, e calcola un valore di discrepanza, rappresentato abitualmente come D che corrisponde alla discrepanza massima in valore assoluto tra la distribuzione osservata e la distribuzione teorica, fornendo contemporaneamente un valore di probabilità P che corrisponde, se stiamo verificando un adeguamento della distribuzione normale, alla probabilità di ottenere una distribuzione che non corrisponda a quella osservata se veramente si fosse ottenuto un campione casuale, di grandezza n, di una distribuzione normale.

Se questa probabilità sarà grande, non ci saranno motivi (statisticamente parlando) per supporre che i nostri dati non provengano da una distribuzione; al contrario se la probabilità sarà piccola, non sarà accettabile ipotizzare questo modello probabilistico per i dati.

PROVA DI F

Test statistico utilizzato per confrontare le varianze.

Il test statistico F sperimentale è quello di contrasto con il test di ANOVA e altre prove di confronto delle varianze.

TEST DI CHI AL QUADRATO

Il test del chi-quadrato è ogni prova di verifica di una ipotesi che si utilizza in statistica: con la variabile casuale chi-quadrato si verifica se l’ipotesi nulla è vera.

Determina se vi è associazione tra le variabili qualitative.

Se il valore-p associato alla statistica di contrasto è minore, l’ipotesi nulla è respinta.

E ‘utilizzato per analizzare tabelle di contingenza e confronto di proporzioni in dati indipendenti.

PROVA ESATTA DI FISHER (p.- 5%)

Permette di valutare l’effetto del caso.

È una prova statistica di significatività usata nell’analisi di campioni di dati categorici di piccole dimensioni.

Si presenta la necessità di eseguire la prova di Fischer quando possediamo dati che si dividono in due categorie in due modi distinti.

Test di significatività statistica utilizzata per confrontare le proporzioni in tabelle di contingenza.

È preferibile alla prova di x2 quando la dimensione del campione è piccola (meno di 30 persone).

È il test statistico di elezione quando il test chi-quadrato non può essere utilizzato in base alle dimensioni del campione insufficiente

PROVA DI MCNEMAR.

Prova statistica utilizzata per confrontare le proporzioni dei dati appaiati.

È un test di significatività statistica per verificare l’ipotesi nulla sulla inesistenza di cambi nel rapporto di soggetti che hanno dimostrato un evento, quando ogni individuo viene valutato due volte (in condizioni differenti) e i dati sono associati.

PROVA BINOMIALE

In statistica, la prova binomiale è una prova esatta della significatività statistica delle deviazioni di una distribuzione teoricamente prevista dalle osservazioni in due categorie.

L’utilizzo più comune della prova binomiale è: ipotesi nulla che due categorie possano occorrere ugualmente.

TEST DI CORRELAZIONE DI PEARSON

Si utilizza per studiare l’associazione tra un fattore di studio e una variabile di risposta quantitativa, misura il grado di associazione tra due variabili prendendo valori tra -1 e 1.

- I valori vicini a 1 indicheranno una forte associazione lineare positiva.

- I valori vicini a -1 indicheranno una forte associazione lineare negativa.

- Valori vicini allo 0 indicheranno nessuna associazione lineare, il che non significa che non possa esistere altro tipo di associazione.

In una ipotesi nulla, prova che le frequenze relative alla occorrenza di eventi osservati seguono una specifica distribuzione di frequenza.

Gli avvenimenti devono essere vicendevolmente estromettenti.

È una prova della qualità della regolazione, che stabilisce se o meno una distribuzione di frequenza osservata differisce da una distribuzione teorica.

COEFFICIENTE DI KAPPA

Il Kappa è un indice di accettazione negli studi inter osservatore, indica il gardo di interrelazione inter osservatore.

Quantifica il livello di accordo inter-osservatore per ridurre la soggettività del metodo utilizzato (test di mobilità) e se il grado di accordo è dovuta al caso (alla sorte).

La percentuale di accordo derivata dall’indice Kappa è utilizzata per le variabili qualitative.

Si parla di coefficiente di Kappa di Cohen per due terapeuti e di Fleiss per più di due terapeuti.

Questo coefficente è compreso tra 0 e 1. 0 corrisponde a una correlazione che è identica a quello riscontrata casualmente, mentre 1 corrisponde a una perfetta correlazione tra le prove.

I valori negativi di solito indicano che vi è disaccordo su come eseguire il metodo tra i terapeuti.

Si calcola come la proporzione di accordo, a prescindere da ciò che ci si aspetterebbe dal caso, che è stata osservata tra due ripetizioni dello stesso strumento (ad esempio: in uno studio compiuto da due osservatori separatamente).

Il coefficiente di correlazione massima è pari a 1.00.

Un valore pari a 0.00 indica nessuna concordanza.

– tra 0.00 e 0.20: leggera.

– tra 0.21 e 0.40: passabile.

– tra 0.41 e 0.60: moderata.

– tra 0.61 e 0.80: importante.

– tra 0.81 e 1.00: perfetta.

Un coefficiente di 0.4 si può considerare come il limite di affidabilità accettabile di un test.

Il Kappa è un “correttore della misura di accordo”.

Come test statistico, il Kappa può verificare che l’accordo superino la fortuità.

|

Tutti i blocchi |

Blocchi C2-C4 |

Blocchi C5-6 |

|

|

Valore del Kappa |

K = 0.675 SE = 0.041 Z = 17.067 |

K = 0.756 SE = 0.045 Z = 16.823 |

K = 0.460 SE = 0.091 Z = 5.039 |

|

Specificità |

98% |

98% |

91% |

|

Sensibilità |

74% |

78% |

55% |

K = coefficiente di Kappa, SE = errore standard, Z =test di specificità della statistica

COEFFICIENTE DI CORRELAZIONE INTRACLASSE (ICC)

Il coefficiente di correlazione intraclasse (ICC) riguarda le variabili qualitative.

Utilizza il modello 2 di Landis e Koch per l’affidabilità inter operatore, il modello 3 per l’affidabilità intra esaminatori (Landis RJ et Koch GG, 1977).

Anche questo indice è compreso tra 0 e 1.

– Il valore 1 corrisponde ad una riproducibilità perfetta tra le misurazioni.

– Il valore 0 indica que esiste la stessa varianza tra le misurazioni effettuate su un singolo paziente rispetto alle misurazioni rilevate tra differenti pazienti.

|

TESTS |

ICC |

KAPPA |

|

Altezza creste iliache |

52 |

0.26 |

|

Altezza SIPS |

75 |

0.54 |

|

TFD |

82 |

0.62 |

|

TFS |

63 |

0.26 |

|

Gillet |

60 |

0.18 |

|

Elevaz attiva gamba estesa |

93 |

0.81 |

|

Joint play |

75 |

0.61 |

|

Thigh thrust |

81 |

0.73 |

|

Separazione |

58 |

0.17 |

|

Gaenslen |

80 |

0.51 |

|

Patrick |

80 |

0.65 |

|

Sacral thrust |

68 |

0.38 |

|

Sensibilità legamento SI. |

91 |

0.83 |

|

Compressione |

85 |

0.59 |

TEST DI CORRELAZIONE DI SPEARMAN

Si tratta di una misura non parametrica di correlazione, assume una funzione monotonica arbitraria per descrivere la relazione tra due variabili, senza fare alcuna ipotesi sulla distribuzione di frequenza delle variabili.

A differenza del coefficiente del test di Pearson, non richiede l’ipotesi che la relazione tra le variabili sia lineare, o che le variabili siano misurate in scale di intervallo; può essere usato per le variabili misurate a livello ordinale.

Si utilizza se non sussistono le condizioni per applicare il test di Pearson.

Si tratta di una variante del test di correlazione di Pearson: si applica quando ogni valore in sé non è tanto importante quanto la sua situazione rispetto agli altri.

I suoi valori sono interpretati esattamente come il coefficiente di correlazione di Pearson.

La correlazione Spearman misura il grado di associazione tra due variabili quantitative che seguono una tendenza sempre crescente o sempre decrescente.

La correlazione Spearman è più generica rispetto al coefficiente di correlazione di Pearson, tuttavia può essere calcolata per i rapporti esponenziali o logaritmici tra le variabili.

TEST DI WILCOXON

Contrasta la ipotesi nulla che un campione derivi da una popolazione in cui la grandezza delle differenze positive e negative tra i valori delle variabili è lo stesso.

Test non parametrico statistico per il confronto di due campioni (due trattamenti).

Le distribuzioni dei dati non devono seguire la distribuzione normale.

È pertanto un test meno restrittivo del test della t-Student.

TEST DI SHAPIRO-WILKS.

Nonostante questo test sia meno conosciuto, è il test che si consiglia per contrastare l’adeguamento dei nostri dati ad una distribuzione normale, soprattutto quando il campione è ridotto (<30).

Misura l’adeguamento del campione ad una retta, quando la si disegna nel foglio probabilistico normale.

TEST “t” DI STUDENT-FISHER

Si utilizza quando si confrontano due gruppi rispetto ad una variabile quantitativa.

In caso contrario, si utilizza un test non parametrico equivalente, come la U de Mann-Whitney.

È utilizzato per il confronto di due medie di popolazioni normali indipendenti.

Test di significatività parametrica statistica per contrastare l’ipotesi nulla rispetto alla differenza tra due medie.

Quando le due medie sono state calcolate da due campioni completamente indipendenti di osservazioni (situazione improbabile, in pratica, almeno da un punto di vista teorico), il test è descritto come non abbinato.

Quando le due medie vengono derivate da osservazioni consecutive sugli stessi soggetti in due situazioni differenti, si confrontano i valori di ciascun soggetto e si applica una prova abbinata.

La prova “t” di Student è un tipo di statistica deduttiva.

Si utilizza per vedere se c’è una differenza significativa tra le medie di due gruppi.

In tutte le statistiche deduttive (inferenziali), si assume che le variabili dipendenti abbiano una distribuzione normale.

Specificare il livello di probabilità (livello alfa, il livello di significatività, p) che siamo disposti ad accettare prima che i dati siano rilevti (p <.05 è un valore comune che viene utilizzato).

Annotazioni sul test di t di Student:

- Quando si studia la differenza tra due medie della popolazione si utilizza la prova di t. vale a dire che si utilizza quando vogliamo confrontare due medie (il resoconto deve essere misurato con una scala ad intervalli o di quoziente).

- Utilizzeremo un test t di Student se vogliamo confrontare il risultato della lettura di uomini e donne.

- Con una prova t, otteniamo una variabile indipendente e una variabile dipendente.

- La variabile indipendente (di genere, in questo caso) può avere solo due livelli (maschio e femmina).

- Se l’indipendente avesse più di due livelli, allora dovremmo usare una analisi della varianza unidirezionale (ANOVA).

- Il test statistico per il t di Student è il valore t. concettualmente, il valore t rappresenta il numero delle unità standard che stanno separando le medie dei due gruppi.

- Con un test t, il ricercatore vuole indicare con un certo grado di confidenza che la differenza ottenuta tra i valori medi dei gruppi del campione è troppo grande per essere un evento casuale.

- Se il nostro test-t produce un valore che genera una probabilità di 0.01, diciamo che la probabilità di ottenere la differenza che incontriamo sarebbe una casualità 1 volta su 100.

Cinque fattori contribuiscono ad indicare se la differenza tra due medie dei gruppi si può considerare significativa:

- Quanto maggiore è la differenza tra le due medie, maggiore è la probabilità che esista una differenza statisticamente significativa.

- La quantità della sovrapposizione che esiste tra i due gruppi (che è una funzione della variazione tra i due gruppi). Quanto minori sono le variazioni che esistono tra i due gruppi, maggiore è la possibilità che esista una differenza statisticamente significativa.

- La diensione del campione è estremamente importante nel determinare la significatività della differenza tra le medie. Aumentando la dimensione del campione, le medie tendono ad essere più stabili e significative.

- Un livello più grande di alfa richiede meno differenza tra le medie (p<.05)

- È necessario utilizzare una ipotesi (con due code) non direttiva.

Presupposti alla base del test di t:

- I campioni sono stati scelti aleatoriamente a partire dalla loro popolazione.

- La popolazione è distribuita normalmente.

- Unimodale (un modo)

- Simmetrico (la metà destra e sinistra sono speculari), lo stesso numero di persone sopra e sotto alla media.

- A campana (altezza massima – moda – nel mezzo).

- Media, moda e mediana si localizzano al centro.

- Asintotica (quanto più si allontana dalla curva della media, più sarà vicina all’asse della X; ma la curva non deve mai toccare l’asse della X).

Il numero delle persone delle popolazioni deve possedere sempre la stessa varianza (s2=s2). Se questo non si verifica, si utilizz un altro calcolo per l’errore standard.

Esistono 2 tipi del test di t di Student.

– Test t per differenze pari (gruppi dipendenti, test di t correlato) : df = n (numero di paia) -1

Questo si riferisce alla differenza tra i valori medi di un solo campione di individui ottenuto prima del trattamento e dopo il trattamento. Può anche confrontare i valori medi di campioni di individui che si associano in un determinato modo (ad esempio i fratelli, madri, figlie, le persone che vengono associate a seconda di particolari caratteristiche).

– Test t per campioni indipendenti

Questo si riferisce alla differenza tra le medie delle due popolazioni.

Fondamentalmente, il procedimento confronta le medie di due campioni che sono state selezionate in modo indipendente le une dalle altre.

Un esempio: confrontare valori matematici di un gruppo sperimentale con un gruppo controllo.

Come decido quale test t devo utilizzare?

Errore tipo I:

- Si rifiuta una ipotesi nulla che sia realmente vera. La probabilità di commettere un errore di tipo I dipende dal livello alfa è stato scelto.

- Se l’alfa probabilità è stato fissata a p <05, allora c’è una probabilità del 5% di commettere un errore di tipo I.

- È possibile ridurre la possibilità di fare un errore di tipo I, fissando un livello inferiore di alfa (p <.01). Il problema è che in questo modo aumenta la possibilità di un errore di tipo II.

Errore tipo II:

- L’errore consiste nel rifiutare una ipotesi nulla falsa.

- L’idea di base per calcolare un test t di Student è trovare la differenza tra le medie dei due gruppi, dividere tale dato per l’errore standard (della differenza): vale a dire, la deviazione standard della distribuzione delle differenze.

- Un intervallo di confidenza per un test t con due code si ottiene moltiplicando i valori critici per l’errore standard, sommando e sottraendo tale valore dalla differenza delle due medie.

- L’effetto grandezza si utilizza per calcolare la differenza pratica. Se ci sono diverse migliaia di pazienti, è molto probabile trovare una differenza statisticamente significativa.

- Altra cosa è sapere se questa differenza sia pratica o significativa.

- Con studi che riguardano le differenze di gruppo, la dimensione dell’effetto è la differenza delle due medie diviso la deviazione standard del gruppo controllo (o la deviazione standard media di entrambi i gruppi se non c’è gruppo di controllo).

- In generale, la dimensione dell’effetto è importante solo se vi è significatività statistica.

- Una dimensione dell’effetto di 2 si considera piccola, 5 si considera media, 8 si considera grande.

TEST DI MANN-WHITNEY

Il test di Mann-Whitney U è uno dei tests di significatività più conosciuti.

È indicata quando due campioni indipendenti di osservazioni si misurano in un livello ordinale, ovvero quando possiamo dire quale è la maggiore tra due osservazioni.

Determina se il grado di coincidenza tra due distribuzioni osservate è inferiore a quello sperato casualmente nella ipotesi nulla che i due campioni provengano da una stessa popolazione.

Test di significatività statistica non parametrica per provare l’ipotesi nulla che il parametro di posizione (generalmente la mediana) sia lo stesso quando si confrontano due gruppi indipendenti, qualunque sia il tipo della distribuzione della variabile (distribuzione normale o di altro tipo).

Si utilizza quando si intende confrontare due popolazioni utilizzando campiono indipendenti: è una alternativa al test di t per confrontare due medie usando campioni indipendenti.

L’ipotesi nulla è che le mediane delle due popolazioni siano uguali e l’ipotesi alternativa può essere che la mediana della popolazione 1 sia maggiore (minore o diversa) della mediana della popolazione 2.

Test di Mann-Whitney per campioni indipendenti:

- Se abbiamo due insiemi di valori di una variabile continua ottenuti in due campioni indipendenti: X1, X2,…, Xn, Y1, Y2,…, Ym, ordineremo assieme tutti i valori in ordine crescente, assegnando loro un grado, correggendo con un grado medio i valori uguali.

- Calcoliamo quindi la somma dei range per le osservazioni del primo campione Sx, e la somma dei range del secondo campione Sy.

- Se i valori della popolazione dalla quale si è ottenuto il campione aleatorio di X si localizza sotto dei valori di Y, allora il capione di X avrà probabilmente range più bassi, il che si rifletterà in un valore più basso di Sx di quello teoricamente probabile.

- Se la più bassa delle somme dei range è eccessivamente bassa, nel caso improbabile in cui la ipotesi nulla fosse vera, questa sarà rifiutata.

TEST DI KRUSKAL-WALLIS

Test della significatività statistica non parametrica per testare l’ipotesi nulla quando i parametri di localizzazione di due o più gruppi sono uguali.

Il test di Kruskal-Wallis è una alternativa al test F di analisi della varianza per gli studi di classificazione semplice. In questo caso si confrontano vari gruppi: si fa utilizzando la mediana di ciascuno dei gruppi, non la media

- Ho: le mediane delle K popolazioni considerate sono uguali a y.

- Ha: almeno una delle popolazioni ha una mediana differente dalle altre.

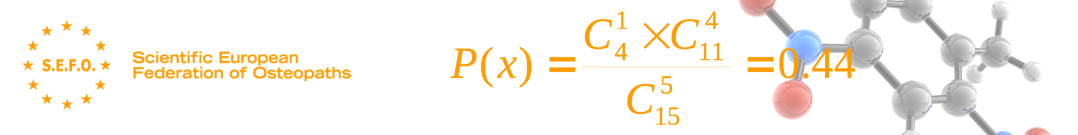

![]()

dove n è il totale dei dati.

Questo contrasto, che è valido solo per variabili continue, confronta la funzione di distribuzione (probabilità cumulativa) teorica con quella osservata, e stima un valore di scarto, solitamente rappresentato come D, che corrisponde alla discrepanza massima tra la distribuzione osservata e la distribuzione teorica, fornendo un valore di probabilità P, che corrisponde, se si verifica un adeguamento della distribuzione normale, alla probabilità di ottenere una distribuzione che non differisca tanto come quella osservata se veramente si avesse ottenuto un campione aleatorio, di grandezza n, di una distribuzione normale.

Se questa probabilità è alta non ci sarà ragione statistica per supporre che i nostri dati non provengano da una distribuzione, mentre se la probabilità è bassa non sarà accettabile supporre questo modello probabilistico per i dati.

TESTS NON PARAMETRICI

L’analisi della varianza assume che le distribuzioni soggiacenti siano distribuite normalmente e che le variazioni delle distribuzioni che vengono confrontate siano simili.

Il coefficiente di correlazione di Pearson assume la normalità.

Mentre le tecniche parametriche sono robuste (vale a dire: hanno spesso un potere considerabile per individuare le differenze o somiglianze incluso quando si violano questi assunti), alcune distribuzioni violano tanto che una alternativa non parametrica è più accettabile per individuare una differenza o una somiglianza.

Prove non parametriche per campioni correlati

|

Test |

Num delle variabili |

Variabili |

Obiettivo |

|

McNemar |

2 |

Qualitative: 2 valori |

Determinare se la differenza tra le distribuzioni di frequenze dei valori delle due variabili sia statisticamente significativa. |

|

Signos |

2 |

In scala per lo meno ordinale |

Determinare se la differenza tra il numero di volte in cui il valore di una variabile è maggiore che quella dell’altra, e il numero di volte in cui è minore è statisticamente significativo. |

|

Wilcoxon |

2 |

In scala per lo meno ordinale |

Determinare se il divario tra la grandezza delle differenze positive tra i valori delle due variabili e la grandezza delle differenze negative sia statisticamente significativa. |

|

Q di Cochran |

p > 2 |

Qualitative: 2 valori |

Determinare se le differenze tra le distribuzioni di frequenze dei valori delle p variabili siano statisticamente significative. |

|

F di Friedman |

p > 2 |

In scala per lo meno ordinale |

Determinare se le differenze tra le distribuzioni delle p variabili siano statisticamente significative. |

SCELTA DELLA TECNICA STATISTICA APPROPRIATA

Con gli elementi definiti nei paragrafi precedenti, si possono stabilire diagrammi decisionali per guidare nella scelta della tecnica o test statistico appropriato.

Esistono più di 300 tests statistici di base, per cui è difficile poterle presentare in forma esaustiva in questo capitolo.

|

Criterio |

Descrizione |

Spiegazione |

|

1 |

Statistica descrittiva |

Nessun contenuto statistico o unicamente statistica descrittiva |

|

2 |

Test t di Student , tests z |

Per un campione o due campioni (dati affiancabili e/o indipendenti). |

|

3 |

Tabelle bivariabili |

Chi quadrato, test esatto di Fisher, test di MCNemar |

|

4 |

Tests non parametrici |

Test dei segni. U di Mann-Whitney, test t di Wilcoxon |

|

5 |

Statistiche demo-epidemiologiche |

Rischio relativo. Odds ratio. Log. Odds. Misure di associazione. Sensibilità e specificità |

|

6 |

Correlazione lineare di Pearson |

Correlazione classica (coefficiente r di correlazione lineare) |

|

7 |

Correlazione lineare di Pearson |

Correlazione classica (coefficiente r di correlazione lineare) |

|

8 |

Regressione semplice |

Minimi quadrati di regressione con un produttore e una variabile risposta |

|

9 |

Analisi della varianza |

ANOVA, analisi della covarianza, tests F |

|

10 |

Trasformazione delle variabili |

Utilizzo di trasformazioni (logaritmiche…) |

|

11 |

Correlazione non parametrica |

Rho di Spearman, Tau di Kendall, tests di tendenza |

|

12 |

Regressione multipla |

Include la regressione polinomica e la regressione passo a passo |

|

13 |

Comparazioni multiple |

Comparazioni multiple |

|

14 |

Aggiustamento e standardizzazione |

Standardizzazione di tassi di incidenza e prevalenza |

|

15 |

Tavole multivariabili |

Procedimenti di Mantel-Haenszel- modelli log. lineari |

|

16 |

Potenza e dimensioni del campione |

Determinazione della dimensione del campione in base ad una differenza dimistrabile |

|

17 |

Analisi della sopravvivenza |

Include tabelle di vita, regressione della sopravvivenza e altre analisi della sopravvivenza |

|

18 |

Analisi costi-benefici |

Stima dei costi della saluteper confrontare vie differenti (costo-efficacia) |

|

19 |

Altre analisi |

Test non incluso nelle categorie precedenti: analisi di sensibilità, analisi cluster. Analisi discriminante. |

Protocollo elaborato da EMERSON e COLDTIZ e adattato da MORA RIPOLL e COLS. Livelli di riferimento per l’analisi di accessibilità.

I PASSI SUCCESSIVI

Una volta realizzate le statistiche si deve continuare a:

- Analisi qualitativa o quantitativa.

- Sintesi ed interpretazione finale dei dati già anaizzati.

- Stesura del rapporto di ricerca.