Indispensables, ce sont des tests mathématiques qui sont appliqués aux statistiques pour déterminer leur degré de certitude et leur signification.

Les méthodes statistiques interférentielles non paramétriques:

Ce sont des procédés mathématiques qui servent à tester l’hypothèse statistique qui, contrairement des statistiques paramétriques, ne font aucune assomption sur les distributions de fréquence des variables qui sont déterminées.

Le niveau de mesure peut être nominal ou ordinal.

L’échantillon n’a pas besoin aléatoire.

La distribution de la fréquence n’a pas besoin d’être normale.

On peut utiliser des échantillons plus petits.

Les méthodes statistiques déductives paramétriques:

Ce sont les procédures mathématiques pour tester l’hypothèse statistique qui assument que les distributions de variables déterminées ont certaines caractéristiques.

Le niveau de mesure doit être rationnel ou intervallaire.

L’échantillon doit être aléatoire.

La distribution de la fréquence doit être normale.

La variation des résultats entre chaque fréquence doit être similaire.

| Variable de rèponse | ||||

|---|---|---|---|---|

|

Facteur d’étude |

Qualitative nominale |

Qualitative nominale |

Qualitative |

Quantitative |

|

Qualitatif (deux groupes) |

||||

|

Indépendants |

Z de comparaison de proportions. |

Chi au carré. |

OU de Mann-Whitney. |

t de Student-Fisher.

|

|

Appariés |

Épreuve de McNemar. |

Q de Cochran. |

Épreuve des signes. |

t de Student-Fisher pour données appariées. |

|

Qualitatif (plus de deux groupes)) |

||||

|

Indépendants |

Chi au carré. |

Chi au carré. |

Épreuve de Kruskal-Wallis. |

Analyse de la variance. |

|

Appariés |

Q de Cochran. |

Q de Cochran. |

Épreuve de Friedman. |

Analyse de la variance de deux voies. |

|

Quantitatif |

t de Student-Fisher. |

Analyse de la variance. |

Corrélation de Spearman. |

Corrélation de Pearson. |

Quand les tests statistiques applicables aux variables quantitatives n’accompliront les assomptions nécessaires pour leur application, on doit utiliser les tests correspondants comme si les variables de réponse étaient une variable ordinale (tests non paramétriques).

ÉPREUVE DE KOLMOGOROV-SMIRNOV

C’est une épreuve de signification statistique non paramétrique pour contraster l’hypothèse nulle quand les paramètres de localisation des deux groupes seront égaux.

Ce contraste, qui est valable uniquement pour les variables continues, compare la fonction de distribution (probabilité accumulée) théorique avec celle observée, et calcule une valeur de différence, représentée habituellement comme D, qui correspond à la différence maximale en valeur absolue entre la distribution observée et la distribution théorique, en fournissant une valeur de probabilité P, qui correspond, si nous vérifions un ajustement à la distribution normale, à la probabilité d’obtenir une distribution qui diverge autant que celle observée si on avait vraiment obtenu un échantillon aléatoire, de taille n, d’une distribution normale.

Si cette probabilité est grande il n’y aura pas par conséquent de raisons statistiques pour supposer que les données ne viennent pas d’une distribution, tandis que si elle est très petite, il sera impossible d’accepter ce modèle probabiliste pour les données.

ÉPREUVE DE F

Il s’agit d’une épreuve statistique qui sert à comparer des variances.

La statistique F expérimentale est la statistique de contraste dans l’ANOVA et dans d’autres tests de comparaison de variances.

TEST DE CHI AU CARRÉ

L’épreuve de Chi-carré est toute épreuve statistique de l’hypothèse dans laquelle le test statistique de la distribution du Chi-carré si l’hypothèse nulle est vrai.

Il détermine s’il existe une association entre des variables qualitatives.

Si la valeur P associée à la statistique de contraste est plus petite on rejettera l’hypothèse nulle.

Il est utilisé pour analyser des tableaux de contingence et de comparaison de proportions de données indépendantes

ÉPREUVE EXACTE DE FISCHER (P – 5%)

Elle permet d’évaluer l’effet du hasard.

C’est une épreuve statistique de signification utilisée dans l’analyse de petites tailles catégoriques d’échantillon de données.

La nécessité de l’épreuve de Fischer se présente quand nous aurons des données qui se divisent deux catégories de deux manières séparées.

C’est l’épreuve de signification statistique utilisée pour comparer des proportions dans des tableaux de contingence.

Elle est préférable à l’épreuve de Chi carré quand la taille de l’échantillon sera réduite (moins de 30 effectifs).

C’est l’épreuve statistique d’élection quand l’épreuve de Chi carré ne pourra pas être employée à cause d’une taille d’échantillonnage insuffisante.

ÉPREUVE DE MCNEMAR.

C’est une épreuve statistique qui sert à comparer des proportions dans des données des appariées.

Il s’agit d’une épreuve de signification statistique pour prouver l’hypothèse nulle d’inexistence de modifications dans la proportion de sujets qui expérimentent un événement, quand chaque individu est évalué deux fois (dans des conditions différentes) et que les données sont appariées.

ÉPREUVE BINÔMIALE

En statistique, l’épreuve binomiale est une épreuve exacte de la signification statistique de déviations d’une distribution théoriquement pourvue d’observations dans deux catégories.

L’utilisation la plus commune de l’épreuve binomiale est dans le cas où l’hypothèse nulle est que deux catégories sont également probables de se produire.

TEST DE CORRÉLATION DE PEARSON

Il est utilisé pour étudier l’association entre un facteur d’étude et une variable de réponse quantitative, il mesure le degré d’association entre deux variables en prenant des valeurs entre -1 et 1.

- Des valeurs proches de 1 indiqueront une forte association linéaire positive.

- Des valeurs proches de -1 indiqueront une forte association linéaire négative.

- Des valeurs proches de 0 indiqueront un non association linéaire, ce qui ne signifie pas qu’il ne puisse pas exister un autre type d’association.

Il teste dans une hypothèse nulle que les fréquences relatives de la présence d’événements observés suivent une distribution de fréquence spécifiée.

Les événements doivent mutuellement être exclusifs.

C’est une épreuve de la qualité d’ajustement qui établit si oui on un effet ou une distribution de fréquence observée se différencie d’une distribution théorique.

COEFFICIENT DE KAPPA

Le Kappa est un indexe omnibus d’acceptation dans les études inter-observateurs, il indique le degré d’interrelation inter-observateur.

Il permet de quantifier le niveau de l’accord inter-observateur pour diminuer la subjectivité d’une méthode utilisée (test de mobilité) et si le degré d’accord est du au hasard (à la chance).

Le pourcentage d’accord accompagné de l’indexe de Kappa est utilisé pour les variables qualitatives.

On parle du coefficient de Kappa de Cohen pour deux thérapeutes et de Fleiss pour plus de deux thérapeutes.

Ce coefficient est compris entre 0 et 1. 0, 0 correspond à une corrélation qui est identique à celle trouvée par hasard et 1 à une corrélation parfaite entre les examinateurs.

Les valeurs négatives indiquent habituellement qu’il existe un désaccord dans la manière d’effectuer la méthode entre les thérapeutes.

Il calcule la proportion d’accord, différente de celle due au hasard, qui a été observé entre deux répétitions utilisant le même instrument (par exemple, un jugement effectué par deux observateurs séparément).

Le coefficient maximal d’accord est de 1.00.

Une valeur de 0.00 indique qu’il n’existe aucun accord.

– entre 0.00 et 0.20 : léger.

– entre 0.21 et 0.40 : passable

– entre 0.41 et 0.60 : modéré

– entre 0.61 et 0.80 : important

– entre 0.81 et 1.00 : parfaite.

Un coefficient de 0.4 peut être considéré comme la limite de fiabilité acceptable d’une épreuve .

Le kappa est ” un correcteur de la mesure d’accord “.

Comme test de statistique, le kappa peut vérifier que l’accord dépasse les niveaux de la chance.

Tous les blocs |

bloc C2-C4 | bloc C5-6 | |

|---|---|---|---|

| Valeur du Kappa | K = 0.675 SE = 0.041 Z = 17.067 |

K = 0.756 SE = 0.045 Z = 16.823 |

K = 0.460 SE = 0.091 Z = 5.039 |

| Spécificité | 98% | 98% | 91% |

| Sensibilité | 74% | 78% | 55% |

K = coefficient de Kappa, SE = erreur standard, Z =Test de spécificité de la statistique.

COEFFICIENT DE CORRÉLATION INTRACLASSE (ICC)

Le coefficient de corrélation intraclasse (ICC) s’utilise pour les variables quantitatives.

Il utilise le modèle 2 de Landis et Koch pour la fiabilité inter-examinateur, et le modèle 3 pour la fiabilité inter-examinateurs (Landis RJ et Koch GG, 1977).

Cet indexe est aussi compris entre 0 et 1.

– La valeur 1 correspond à une reproductivité parfaite entre les mesures.

– La valeur 0 indique qu’il existe la même variance entre les mesures prises sur un seul patient qu’avec les mesures prises entre différents patients.

| TESTS | ICC | KAPPA |

|---|---|---|

| Hauteur des crêtes iliaques | 52 | 0.26 |

| Hauteur des EIPS | 75 | 0.54 |

| TFD | 82 | 0.62 |

| TFS | 63 | 0.26 |

| Gillet | 60 | 0.18 |

| Elev. jambe étendue active | 93 | 0.81 |

| Jeu articulaire | 75 | 0.61 |

| Thigh thrust | 81 | 0.73 |

| Séparation | 58 | 0.17 |

| Gaenslen | 80 | 0.51 |

| Patrick | 80 | 0.65 |

| Thrust sacré | 68 | 0.38 |

| Sensibilité ligament SI. | 91 | 0.83 |

| Compression | 85 | 0.59 |

TEST DE CORRÉLATION DE SPEARMAN

C’est une mesure non paramétrique de corrélation, il assume une fonction monotonique arbitraire pour décrire la relation entre deux variables, sans faire aucune assomption sur la distribution de fréquence des variables.

À la différence du coefficient du test de Pearson, il ne requiert pas l’assomption que la relation entre les variables est linéaire, ni que les variables sont des mesures dans des échelles d’intervalle ; il peut être utilisé pour des mesures variables en niveau ordinal.

Il est utilisé si les conditions d’application du test de Pearson ne se sont pas remplies.

C’est une variante du test de corrélation de Pearson, il est appliqué quand chaque valeur est aussi importante que sa situation.

Ses valeurs sont interprétées de la même manière que celles du coefficient de corrélation de Pearson.

La corrélation de Spearman mesure le degré d’association entre deux variables quantitatives qui suivent une tendance toujours croissante ou toujours décroissante.

Il est plus général que le coefficient de corrélation de Pearson, la corrélation de Spearman, par contre peut être calculé pour des relations exponentielles ou logarithmiques entre les variables.

TEST DE WILCOXON

Il contraste l’hypothèse nulle que l’échantillon vient d’une population dans laquelle la magnitude des différences positives et négatives entre les valeurs des variables est la même.

C’est une épreuve statistique non paramétrique qui sert à la comparaison de deux échantillons (deux traitements).

Les distributions des données n’ont pas besoin de suivre la distribution normale.

C’est par conséquent une épreuve moins restrictive que l’épreuve t-Student.

ÉPREUVE DE SHAPIRO-WILKS.

Bien que cette épreuve soit moins de connue, c’est est celle qui est recommandée pour contraster l’ajustement des données à une distribution normale, surtout quand l’échantillon sera petit (n<30).

Elle mesure l’ajustement de l’échantillon à une droite, en la dessinant sur papier probabiliste normal.

ÉPREUVE « T » DE STUDENT-FISHER

Ce test s’utilise si on compare deux groupes en ce qui concerne une variable quantitative.

Dans le cas contraire, on utilise une épreuve équivalente non paramétrique, comme l’U de Mann-Whitney.

Elle est utilisée pour la comparaison de deux moyennes de populations indépendantes et normales.

C’est une épreuve de signification statistique paramétrique qui permet de contraster l’hypothèse nulle en ce qui concerne la différence entre deux moyennes.

Quand les deux moyennes ont été calculées à partir de deux échantillons complètement indépendants d’observations (situation peu probable dans la pratique, au moins d’un point de vue théorique), l’épreuve est décrite comme non appariée.

Quand les deux moyennes ont été extraites d’observations consécutives chez les mêmes sujets dans deux situations différentes, on compare les valeurs de chaque individu, et on applique une épreuve appariée.

L’épreuve « t » de Student est un type de statistique déductive qui est utilisé pour déterminer s’il y a une différence significative entre les moyennes de deux groupes.

Avec toute la statistique déductive, on assume que les variables dépendantes ont une distribution normale.

Il faut spécifier le niveau de la probabilité (niveau d’alpha, niveau de signification, p) que nous l’on est disposé à accepter (p < .05 est une valeur commune qui est utilisée).

Remarque sur l’épreuve t de Student:

- Quand la différence entre deux moyennes de la population se recherche, on utilise une épreuve t. C’est-à-dire qu’elle est utilisée quand nous souhaitons comparer deux moyennes (les comptes doivent être mesurés dans une échelle d’intervalle ou de quotient).

- Avec une épreuve t, nous avons une variable indépendante et une dépendante.

- La variable indépendante peut seulement avoir deux niveaux.

- Si la variante indépendante a plus de deux niveaux, nous utiliserions ensuite une analyse de la variation unidirectionnelle (ANOVA).

- L’épreuve statistique pour t de Student est la valeur t. Conceptuellement, la valeur t représente le nombre d’unités standard qui séparent les moyennes des deux groupes.

- Avec une épreuve t, le chercheur souhaite indiquer avec un certain degré de confiance que la différence obtenue entre les moyennes des groupes de l’échantillon est trop grand pour être attribué à la chance.

- Si l’épreuve t produit une valeur t qui donne lieu à une probabilité de .01, nous disons que la probabilité d’obtenir la différence que nous trouvons serait due au hasard 1 fois sur 100.

Cinq facteurs contribuent pour indiquer si la différence entre deux moyennes des groupes peut être considérée significative :

- D’autant plus grande est la différence entre les deux moyennes, plus grande est la probabilité qu’une différence statistique significative existe.

- D’autant plus petites sont les variations qui existent entre les deux groupes, plus grande est la probabilité qu’une différence statistique significative existe.

- La taille de l’échantillon est extrêmement importante dans la détermination de la signification de la différence entre les moyennes. En augmentant la taille de l’échantillon, les D’autant tendent à être plus stables et plus représentatives.

- Un niveau plus grand d’alpha requiert moins de différence entre les moyennes (p < .05).

- On doit utiliser une hypothèse avec deux queues non directrices.

Assomptions sous-jacentes l’épreuve de t :

- Les échantillons ont été aléatoirement répartis à partir de leurs populations respectives.

- La population doit normalement être distribuée.

- Mode unimodal.

- Symétrique (les moitiés gauches et droites sont des images miroir), le même nombre de gens en au dessus ou en-dessous de la moyenne.

- En forme de cloche de hauteur maximale (mode) dans le centre.

- Moyenne, mode, et médiane sont localisée dans le centre.

- Asyntonique (plus on s´éloigne de la courbe de la moyenne, plus proche l’on sera de l’axe X ; mais la courbe ne doit jamais toucher l’axe de X).

- Le nombre de personnes dans les populations doit avoir la même variance (s2 = s2) .Si n’est pas le cas il faut utiliser un autre calcul pour l’erreur standard.

Il existe 2 types d’épreuve t de Student

– Test t pour différence paire (groupes dépendants, test t correlationné) : df= n (nombre de paires) -1

Ceci se réfère à la différence entre les comptes moyens d’un seul échantillon d’individus qui est déterminé avant le traitement et après le traitement. Il peut aussi comparer les comptes des moyennes d’échantillons d’individus qui sont appariés d’une certaine manière (par exemple les frères, les mères, filles, les personnes qui sont appariés en termes des caractéristiques particulières).

– Test t pour échantillons indépendants

Ceci se réfère à la différence entre les moyennes de deux populations.

Basiquement, la procédure compare les moyennes de deux échantillons qui ont été indépendamment choisi l’une de l’autre. Un exemple serait de comparer des comptes mathématiques d’un groupe expérimental avec ceux d’un groupe de contrôle.

Comment décider quel type d’épreuve t il faut uziliser ?

Erreur type I :

- Elle rejette une hypothèse nulle qui est réellement vraie. La probabilité de faire une erreur type I dépend du niveau alpha qui se choisit.

- Si on a fixé la probabilité alpha à p < 05, il existe alors 5% de possibilités de faire une erreur de type I.

- On peut réduire la possibilité de faire une erreur type I en fixant un niveau alpha plus petit (p < .01). Le problème en faisant ceci est qu’on augmente la possibilité d’une erreur type II.

Erreur type II :

- Elle ne permet pas de rejeter une hypothèse nulle qui est fausse.

- L’idée de base pour calculer une épreuve t de Student est de trouver la différence entre les moyennes des deux groupes et de la diviser par l’erreur standard (de la différence), c’est-à-dire la déviation standard de la distribution des différences.

- Un intervalle de confiance pour une épreuve t avec deux queues est calculé en multipliant les valeurs critiques par l’erreur de standard et en ajoutant et en ôtant cela de la différence des deux moyennes.

- L’effet taille est utilisé pour calculer la différence pratique. S’il existe plusieurs milliers de patients, il est très facile de trouver une différence statistiquement significative. Savoir si cette différence est pratique ou significative est autre question.

- Avec les études en impliquant des différences de groupe, la taille de l’effet est la différence des deux moyennes divisée par la déviation standard du groupe contrôle (ou la déviation standard moyenne des deux groupes s’il n’y a pas de groupe contrôle).

- Généralement, la taille de l’effet est seulement importante s’il existe une signification statistique.

- Un effet taille de 2 est considéré comme petit, 5 se considère comme moyen, et 8 est considérées comme grand.

TEST DE U MANN-WHITNEY

L’épreuve de U Mann-Whitney est un des tests de signification les plus connus.

Il est approprié quand deux échantillons indépendants d’observations seront mesurés à un niveau ordinal, c’est-à-dire que nous pouvons dire quelle est la plus grande de ces deux observations.

Il détermine si le degré de coïncidence entre deux distributions observées est inférieur à celui attendu par chance dans l’hypothèse nulle que les deux échantillons viennent d’une même population.

C’est une épreuve de signification statistique non paramétrique pour prouver l’hypothèse nulle que le paramètre de localisation (généralement la moyenne) est le même quand on compare deux groupes indépendants, quel que soit le type de distribution de la variable (distribution normale ou d’un autre type).

Il est utilisé quand on voudra comparer deux populations en utilisant des échantillons indépendants, c’est-à-dire que c’est une épreuve alternative à l’épreuve de t pour comparer deux moyennes en utilisant des échantillons indépendants.

L’hypothèse nulle est que la moyenne des deux populations est égale et l’hypothèse alternative peut être que la moyenne de la population 1 est plus grande (plus petite ou différente) de la moyenne de la population 2.

Épreuve d’U Mann-Whitney pour échantillons indépendants:

- Lorsqu’il existe deux séries de valeurs d’une variable continue obtenues à partir de deux échantillons indépendants : X1, X2,…, Xn, Y1, Y2,…, Ym, on ordonne conjointement toutes les valeurs en sens croissant, en leur assignant leur rang, en corrigeant avec le rang moyen des matches nuls.

- On calcule ensuite la somme des rangs pour les observations du premier échantillon Sx, et la somme de rangs du second échantillon Sy.

- Si les valeurs de la population dont on a extrait l’échantillon aléatoire de X sont localisées en dessous les valeurs d’Y, alors l’échantillon de X aura probablement des rangs inférieurs, ce qui se reflétera dans une valeur plus petite de Sx du théoriquement probable.

- Si la plus petite des sommes des rangs est excessivement basse, ce qui est très peu probable dans le cas où l’hypothèse nulle serait vraie, celle-ci sera rejetée.

ÉPREUVE DE KRUSKAL-WALLIS

C’est une épreuve de signification statistique non paramétrique pour contraster l’hypothèse nulle quand les paramètres de localisation de deux groupes ou plus seront égaux.

L’épreuve de Kruskal-Wallis, est une alternative à l’épreuve F d’analyse de variance pour des conceptions de classification simple. Dans ce cas on compare plusieurs groupes mais en utilisant la médiane de chacun d’eux, au lieu des moyennes.

· Ho : La moyenne des k des populations considérées sont égales et,

· Ha : Au moins une des populations a une moyenne différente à celle des autres.

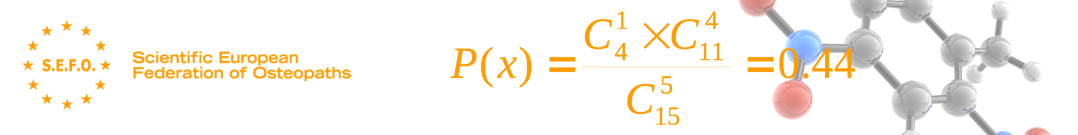

![]()

Où, n est le total de données.

Ce contraste, qui est valable uniquement pour des variables continues, compare la fonction de distribution (probabilité accumulée) théorique avec celle observée, et calcule une valeur de différence, représentée habituellement comme D, qui correspond à la différence maximale en valeur absolue entre la distribution observée et la distribution théorique, en fournissant de même une valeur de probabilité P, qui correspond, si on vérifie un ajustement à la distribution normale, à la probabilité d’obtenir une distribution qui diverge autant que celle observée si on avait vraiment obtenu un échantillon aléatoire, de taille n, de distribution normale.

Si cette probabilité est grande il n’y aura pas par conséquent de raisons statistiques pour supposer que les données ne proviennent pas d’une distribution, tandis que si elle est très petite, ce modèle probabiliste ne sera pas accepté pour les données.

TESTS NON-PARAMÉTRIQUES

L’analyse de la variation assume que les distributions sous-jacentes sont distribuées normalement et que les variations des distributions qui sont comparées sont semblables.

Le coefficient de corrélation de Pearson assume une normalité.

Tandis que les techniques paramétriques sont robustes (c’est-à-dire, qu’elles conservent souvent un pouvoir considérable pour détecter des différences ou des similitudes même quand on violera cette assomption), quelques distributions violent tellement cette règle qu’un alternative non paramétrique est plus désirable pour détecter une différence ou une similitude.

Tests non paramétriques pour échantillons en relation

| Épreuve | Nombre de variables |

Variables | Objectif |

|---|---|---|---|

| McNemar | 2 | Qualitatives : 2 valeurs |

Déterminer si la différence entre les distributions de fréquences des valeurs des deux variables est statistiquement significative. |

| Signes | 2 | En échelle au moins ordinale |

Déterminer si la différence entre le nombre de fois où la valeur d’une variable est plus grande que celle de l’autre et le nombre de fois qu’elle est plus petite est statistiquement significative. |

| Wilcoxon | 2 | En échelle au moins ordinale | Déterminer si la différence entre la magnitude des différences positives entre les valeurs des deux variables et la magnitude des différences négatives est statistiquement significative. |

| Q de Cochran | p > 2 | Qualitatives : 2 valeurs |

Déterminer si les différences entre les distributions de fréquences des valeurs des variables p sont statistiquement significatives. |

| F de Friedman | p > 2 | En échelle au moins ordinale | Déterminer si les différences entre les distributions des variables p sont statistiquement significatives. |

CHOIX DE LA TECHNIQUE STATISTIQUE APPROPRIÉE

Avec les éléments définis dans les paragraphes antérieurs on peut établir des arbres de décision pour s’aider dans le choix de la technique ou du test statistique approprié.

Il existe plus de 300 tests statistiques de base, ce pourquoi il est difficile de pouvoir les aborder toutes de manière exhaustive.

|

Criterio |

Descripción |

Aclaraciones |

|---|---|---|

|

1 |

Statistique descriptive

|

Aucun contenu statistique ou uniquement statistique descriptive

|

|

2 |

Tests t de Student, tests z

|

Pour un échantillon ou deux échantillons (données appariées et/ou indépendants)

|

|

3 |

Tableaux bivariables

|

Chi carré, épreuve exacte de Fisher, test de MC Nemar

|

|

4 |

Tests non paramétriques

|

Test des signes. U de Mann-Whitney, épreuve t de Wilcoxon

|

|

5 |

Statistiques démo-épidémiologiques

|

Risque relatif. Odds ratio. Log. Odds. Mesures d’association. Sensibilité et spécificité

|

|

6 |

Corrélation linéaire de Pearson

|

Corrélation classique (coefficient r de corrélation linéaire)

|

|

7 |

Régression simple

|

Régression de minimum carré avec une variable productrice et une réponse

|

|

8 |

Analyse de variance

|

ANOVA, analyse de la covariance, tests F

|

|

9 |

Transformation de variables

|

Emploi de transformations (logarithmiques….)

|

|

10 |

Corrélation non paramétrique

|

Rho de Spearman, Tau de Kendall, tests de tendance

|

|

11 |

Régression multiple

|

Elle inclut la régression polynomiale et la régression pas à pas

|

|

12 |

Comparaisons multiples

|

Comparaisons multiples

|

|

13 |

Ajustement et standardisation

|

Standardisation du taux d’incidence et de prévalence

|

|

14 |

Tableaux multivariables

|

Procédures de Mantel-Haenszel. Modèles log. linéaires

|

|

15 |

Puissance et taille de l’échantillonnage

|

Détermination de la taille de l’échantillon avec comme base une différence décelable

|

|

16 |

Analyse de la survie

|

Elle inclut des tableaux vie, régression de survie et d’autres analyses de survie

|

|

17 |

Analyse coût-bénéfice

|

Estimation des coûts de santé pour comparer des directives alternatives (coût efficacité)

|

|

18 |

Autres analyses

|

Test non inclus dans les catégories précédentes : analyse de sensibilité, analyse cluster. Analyse discriminante. |

|

|

Protocole conçu par EMERSON et COLDTIZ et adapté par MORA RIPOLL et COLS.

Niveaux de référence pour l’analyse d’accessibilité.

LES PAS SUIVANTS

Une fois effectuées les statistiques il faut procéder à:

- L’analyse qualitative ou quantitative.

- La synthèse et l’interprétation finale de toutes les données déjà analysées.

- La rédaction du rapport de recherche.